人工智能除了下围棋还能干啥?这篇科普文将震撼你的世界观

编者注:本文由谢熊猫君翻译自 Wait but Why,经译者授权转载于此。原文分两篇:《The AI Revolution: Road to Superintelligence》、《The AI Revolution: Our Immortality or Extinction》。

译者注:人工智能很可能导致人类的永生或者灭绝,而这一切很可能在我们的有生之年发生。

上面这句话不是危言耸听,请耐心的看完本文再发表意见。这篇翻译稿翻译完一共三万五千字,我从上星期开始翻,熬了好几个夜才翻完,因为我觉得这篇东西非常有价值。希望你们能够耐心读完,读完后也许你的世界观都会被改变。

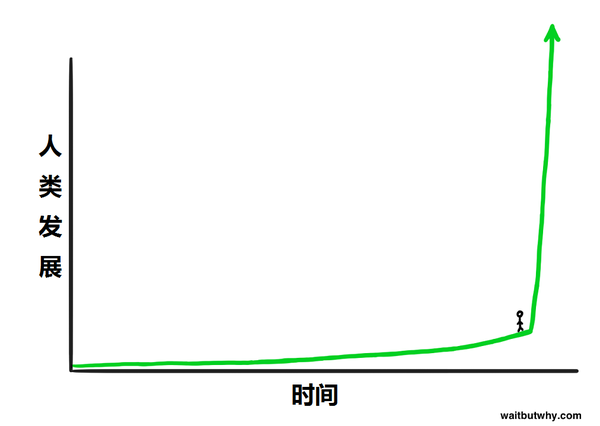

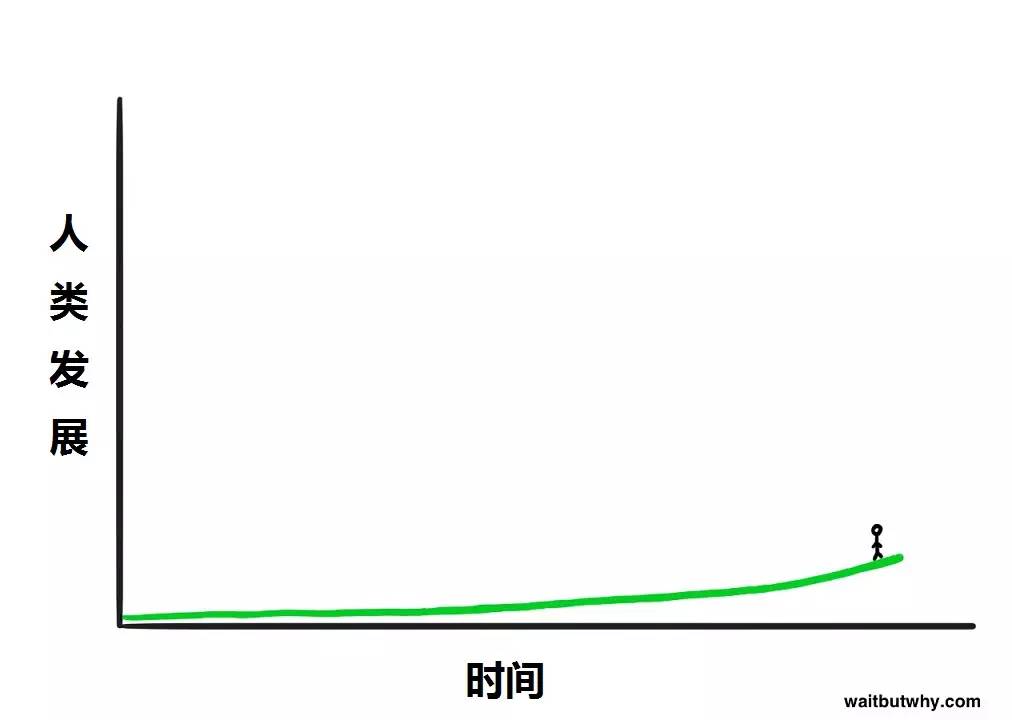

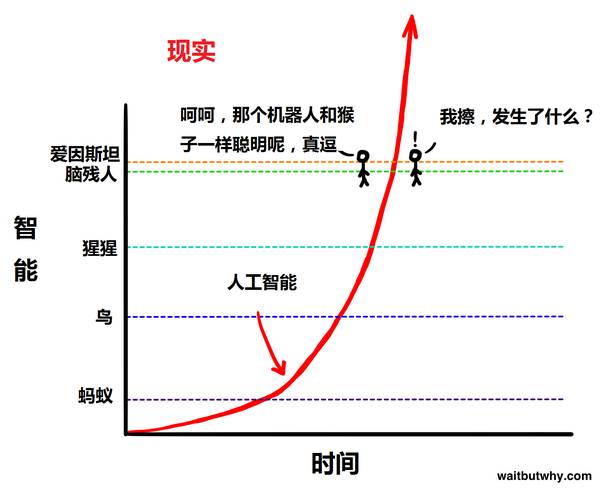

我们正站在变革的边缘,而这次变革将和人类的出现一般意义重大 Vernor Vinge。如果你站在这里,你会是什么感觉? 看上去非常刺激吧?但是你要记住,当你真的站在时间的图表中的时候,你是看不到曲线的右边的,因为你是看不到未来的。所以你真实的感觉大概是这样的:

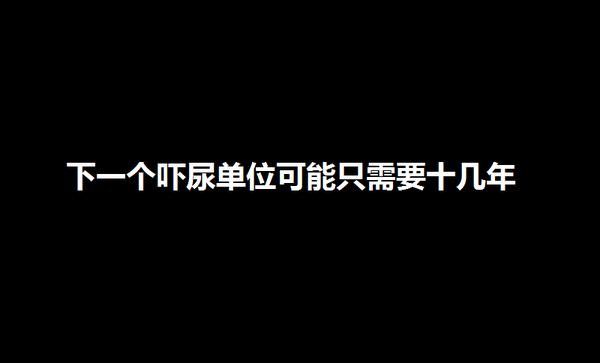

看上去非常刺激吧?但是你要记住,当你真的站在时间的图表中的时候,你是看不到曲线的右边的,因为你是看不到未来的。所以你真实的感觉大概是这样的: 稀松平常。遥远的未来就在眼前想象一下坐时间机器回到 1750 年的地球,那个时代没有电,通讯基本靠吼,交通主要靠动物拉着跑。你在那个时代邀请了一个叫老王的人到 2015 年来玩,顺便看看他对“未来”有什么感受。我们可能没有办法了解 1750 年的老王内心的感受金属铁壳在宽敞的公路上飞驰,和太平洋另一头的人聊天,看几千公里外正在发生进行的体育比赛,观看一场发生于半个世纪前的演唱会,从口袋里掏出一个黑色长方形工具把眼前发生的事情记录下来,生成一个地图然后地图上有个蓝点告诉你现在的位置,一边看着地球另一边的人的脸一边聊天,以及其它各种各样的黑科技。别忘了,你还没跟他解释互联网、国际空间站、大型强子对撞机、核武器以及相对论。这时候的老王会是什么体验?惊讶、震惊、脑洞大开这些词都太温顺了,我觉得老王很可能直接被吓尿了。但是,如果老王回到了 1750 年,然后觉得被吓尿是个很的体验,于是他也想把别人吓尿来满足一下自己,那会发生什么?于是老王也回到了 250 年前的 1500 年,邀请生活在 1500 年的小李去 1750 年玩一下。小李可能会被 250 年后的很多东西震惊,但是至少他不会被吓尿。同样是 250 来年的时间,1750 和 2015 年的差别,比 1500 年和 1750 年的差别,要大得多了。1500 年的小李可能能学到很多神奇的物理知识,可能会惊讶于欧洲的帝国主义旅程,甚至对于世界地图的认知也会大大改变,但是 1500 年的小李,看到 1750 年的交通、通讯等等,并不会被吓尿。所以说,对于 1750 年的老王来说,要把人吓尿,他需要回到更古老的过去比如回到公元前 12000 年,第一次农业革命之前。那个时候还没有城市,也还没有文明。一个来自狩猎采集时代的人类,只是当时众多物种中的一个罢了,来自那个时代的小赵看到 1750 年庞大的人类帝国,可以航行于海洋上的巨舰,居住在“室内”,无数的收藏品,神奇的知识和发现他很有可能被吓尿。小赵被吓尿后如果也想做同样的事情呢?如果他会到公元前 24000 年,找到那个时代的小钱,然后给他展示公元前 12000 年的生活。小钱大概会觉得小赵是吃饱了没事干“这不跟我的生活差不多么,呵呵”。小赵如果要把人吓尿,可能要回到十万年前或者更久,然后用人类对火和语言的掌控来把对方吓尿。所以,一个人去到未来,并且被吓尿,他们需要满足一个“吓尿单位”。满足吓尿单位所需的年代间隔是不一样的。在狩猎采集时代满足一个吓尿单位需要超过十万年,而工业革命后一个吓尿单位只要两百多年就能满足。未来学家 Ray Kurzweil 把这种人类的加速发展称作加速回报定律(Law of Accelerating Returns)。之所以会发生这种规律,是因为一个更加发达的社会,能够继续发展的能力也更强,发展的速度也更快这本就是更加发达的一个标准。19 世纪的人们比 15 世纪的人们懂的多得多,所以 19 世纪的人发展起来速度自然比 15 世纪的人更快。即使放到更小的时间规模上,这个定律依然有效。著名电影《回到未来》中,生活在 1985 年的主角回到了 1955 年。当主角回到 1955 年的时候,他被电视刚出现时的新颖、便宜的物价、没人喜欢电吉他、俚语的不同而震惊。但是如果这部电影发生在 2015 年,回到 30 年前的主角的震惊要比这大得多。一个 2000 年左右出生的人,回到一个没有个人电脑、互联网、手机的 1985 年,会比从 1985 年回到 1955 年的主角看到更大的区别。这同样是因为加速回报定律。1985-2015 年的平均发展速度,要比 1955-1985 年的平均发展速度要快,因为 1985 年的世界比 1955 年的更发达,起点更高,所以过去 30 年的变化要大过之前 30 年的变化。进步越来越大,发生的越来越快,也就是说我们的未来会很有趣对吧?未来学家 Kurzweil 认为整个 20 世纪 100 年的进步,按照 2000 年的速度只要 20 年就能达成2000 年的发展速度是 20 世纪平均发展速度的 5 倍。他认为 2000 年开始只要花 14 年就能达成整个 20 世纪一百年的进步,而之后 2014 年开始只要花 7 年(2021 年),就能达到又一个 20 世纪一百年的进步。几十年之后,我们每年都能达成好几次相当于整个 20 世纪的发展,再往后,说不定每个月都能达成一次。按照加速回报定,Kurzweil 认为 人类在 **21 世纪的进步将是 20 世纪的 1000 **倍。如果Kurzweil等人的想法是正确的,那 2030 年的世界可能就能把我们吓尿了下一个吓尿单位可能只需要十几年,而 2050 年的世界会变得面目全非。

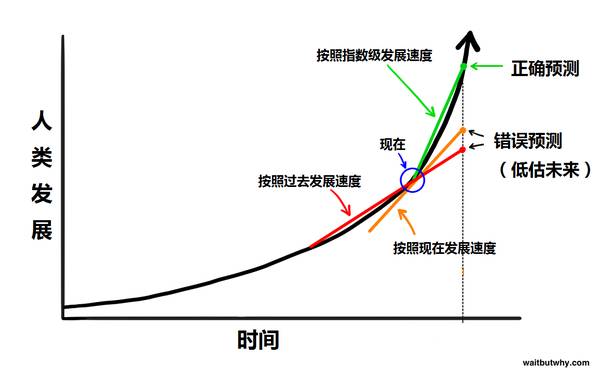

稀松平常。遥远的未来就在眼前想象一下坐时间机器回到 1750 年的地球,那个时代没有电,通讯基本靠吼,交通主要靠动物拉着跑。你在那个时代邀请了一个叫老王的人到 2015 年来玩,顺便看看他对“未来”有什么感受。我们可能没有办法了解 1750 年的老王内心的感受金属铁壳在宽敞的公路上飞驰,和太平洋另一头的人聊天,看几千公里外正在发生进行的体育比赛,观看一场发生于半个世纪前的演唱会,从口袋里掏出一个黑色长方形工具把眼前发生的事情记录下来,生成一个地图然后地图上有个蓝点告诉你现在的位置,一边看着地球另一边的人的脸一边聊天,以及其它各种各样的黑科技。别忘了,你还没跟他解释互联网、国际空间站、大型强子对撞机、核武器以及相对论。这时候的老王会是什么体验?惊讶、震惊、脑洞大开这些词都太温顺了,我觉得老王很可能直接被吓尿了。但是,如果老王回到了 1750 年,然后觉得被吓尿是个很的体验,于是他也想把别人吓尿来满足一下自己,那会发生什么?于是老王也回到了 250 年前的 1500 年,邀请生活在 1500 年的小李去 1750 年玩一下。小李可能会被 250 年后的很多东西震惊,但是至少他不会被吓尿。同样是 250 来年的时间,1750 和 2015 年的差别,比 1500 年和 1750 年的差别,要大得多了。1500 年的小李可能能学到很多神奇的物理知识,可能会惊讶于欧洲的帝国主义旅程,甚至对于世界地图的认知也会大大改变,但是 1500 年的小李,看到 1750 年的交通、通讯等等,并不会被吓尿。所以说,对于 1750 年的老王来说,要把人吓尿,他需要回到更古老的过去比如回到公元前 12000 年,第一次农业革命之前。那个时候还没有城市,也还没有文明。一个来自狩猎采集时代的人类,只是当时众多物种中的一个罢了,来自那个时代的小赵看到 1750 年庞大的人类帝国,可以航行于海洋上的巨舰,居住在“室内”,无数的收藏品,神奇的知识和发现他很有可能被吓尿。小赵被吓尿后如果也想做同样的事情呢?如果他会到公元前 24000 年,找到那个时代的小钱,然后给他展示公元前 12000 年的生活。小钱大概会觉得小赵是吃饱了没事干“这不跟我的生活差不多么,呵呵”。小赵如果要把人吓尿,可能要回到十万年前或者更久,然后用人类对火和语言的掌控来把对方吓尿。所以,一个人去到未来,并且被吓尿,他们需要满足一个“吓尿单位”。满足吓尿单位所需的年代间隔是不一样的。在狩猎采集时代满足一个吓尿单位需要超过十万年,而工业革命后一个吓尿单位只要两百多年就能满足。未来学家 Ray Kurzweil 把这种人类的加速发展称作加速回报定律(Law of Accelerating Returns)。之所以会发生这种规律,是因为一个更加发达的社会,能够继续发展的能力也更强,发展的速度也更快这本就是更加发达的一个标准。19 世纪的人们比 15 世纪的人们懂的多得多,所以 19 世纪的人发展起来速度自然比 15 世纪的人更快。即使放到更小的时间规模上,这个定律依然有效。著名电影《回到未来》中,生活在 1985 年的主角回到了 1955 年。当主角回到 1955 年的时候,他被电视刚出现时的新颖、便宜的物价、没人喜欢电吉他、俚语的不同而震惊。但是如果这部电影发生在 2015 年,回到 30 年前的主角的震惊要比这大得多。一个 2000 年左右出生的人,回到一个没有个人电脑、互联网、手机的 1985 年,会比从 1985 年回到 1955 年的主角看到更大的区别。这同样是因为加速回报定律。1985-2015 年的平均发展速度,要比 1955-1985 年的平均发展速度要快,因为 1985 年的世界比 1955 年的更发达,起点更高,所以过去 30 年的变化要大过之前 30 年的变化。进步越来越大,发生的越来越快,也就是说我们的未来会很有趣对吧?未来学家 Kurzweil 认为整个 20 世纪 100 年的进步,按照 2000 年的速度只要 20 年就能达成2000 年的发展速度是 20 世纪平均发展速度的 5 倍。他认为 2000 年开始只要花 14 年就能达成整个 20 世纪一百年的进步,而之后 2014 年开始只要花 7 年(2021 年),就能达到又一个 20 世纪一百年的进步。几十年之后,我们每年都能达成好几次相当于整个 20 世纪的发展,再往后,说不定每个月都能达成一次。按照加速回报定,Kurzweil 认为 人类在 **21 世纪的进步将是 20 世纪的 1000 **倍。如果Kurzweil等人的想法是正确的,那 2030 年的世界可能就能把我们吓尿了下一个吓尿单位可能只需要十几年,而 2050 年的世界会变得面目全非。 你可能觉得2050年的世界会变得面目全非这句话很可笑,但是这不是科幻,而是比你我聪明很多的科学家们相信的,而且从历史来看,也是逻辑上可以预测的。那么为什么你会觉得“2050年的世界会变得面目全非” 这句话很可笑呢?有三个原因让你质疑对于未来的预测:1. **我们对于历史的思考是线性的。**当我们考虑未来35年的变化时,我们参照的是过去35年发生的事情。当我们考虑21世纪能产生的变化的时候,我们参考的是20世纪发生的变化。这就好像1750年的老王觉得1500年的小李在1750年能被吓尿一样。线性思考是本能的,但是但是考虑未来的时候我们应该指数地思考。一个聪明人不会把过去35年的发展作为未来35年的参考,而是会看到当下的发展速度,这样预测的会更准确一点。当然这样还是不够准确,想要更准确,你要想象发展的速度会越来越快。

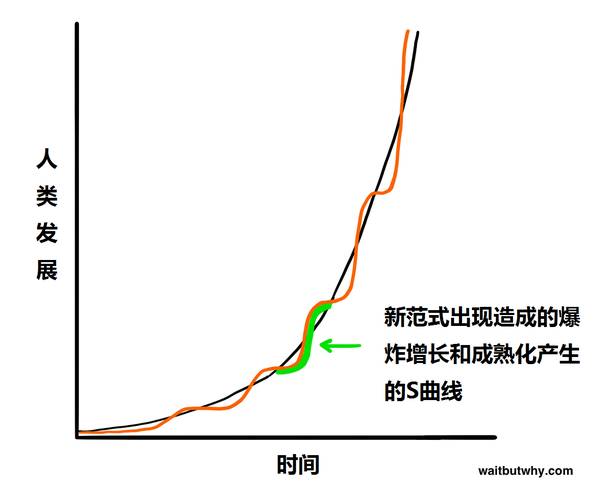

你可能觉得2050年的世界会变得面目全非这句话很可笑,但是这不是科幻,而是比你我聪明很多的科学家们相信的,而且从历史来看,也是逻辑上可以预测的。那么为什么你会觉得“2050年的世界会变得面目全非” 这句话很可笑呢?有三个原因让你质疑对于未来的预测:1. **我们对于历史的思考是线性的。**当我们考虑未来35年的变化时,我们参照的是过去35年发生的事情。当我们考虑21世纪能产生的变化的时候,我们参考的是20世纪发生的变化。这就好像1750年的老王觉得1500年的小李在1750年能被吓尿一样。线性思考是本能的,但是但是考虑未来的时候我们应该指数地思考。一个聪明人不会把过去35年的发展作为未来35年的参考,而是会看到当下的发展速度,这样预测的会更准确一点。当然这样还是不够准确,想要更准确,你要想象发展的速度会越来越快。 2. **近期的历史很可能对人产生误导。**首先,即使是坡度很高的指数曲线,只要你截取的部分够短,看起来也是很线性的,就好像你截取圆周的很小一块,看上去就是和直线差不多。其次,指数增长不是平滑统一的,发展常常遵循 S 曲线。

2. **近期的历史很可能对人产生误导。**首先,即使是坡度很高的指数曲线,只要你截取的部分够短,看起来也是很线性的,就好像你截取圆周的很小一块,看上去就是和直线差不多。其次,指数增长不是平滑统一的,发展常常遵循 S 曲线。 S 曲线发生在新范式传遍世界的时候,S 曲线分三部分

S 曲线发生在新范式传遍世界的时候,S 曲线分三部分慢速增长(指数增长初期)

快速增长(指数增长的快速增长期)

随着新范式的成熟而出现的平缓期

汽车上有很多的弱人工智能系统,从控制防抱死系统的电脑,到控制汽油注入参数的电脑。谷歌正在测试的无人驾驶车,就包括了很多弱人工智能,这些弱人工智能能够感知周围环境并作出反应。

你的手机也充满了弱人工智能系统。当你用地图软件导航,接受音乐电台推荐,查询明天的天气,和 Siri 聊天,以及其它很多很多应用,其实都是弱人工智能。

垃圾邮件过滤器是一种经典的弱人工智能它一开始就加载了很多识别垃圾邮件的智能,并且它会学习并且根据你的使用而获得经验。智能室温调节也是一样,它能根据你的日常习惯来智能调节。

你在上网时候出现的各种其它电商网站的产品推荐,还有社交网站的好友推荐,这些都是弱人工智能的组成的,弱人工智能联网互相沟通,利用你的信息来进行推荐。网购时出现的“买这个商品的人还购买了”推荐,其实就是收集数百万用户行为然后产生信息来卖东西给你的弱人工智能。

谷歌翻译也是一种经典的人工智能非常擅长单个领域。声音识别也是一种。很多软件利用这两种智能的合作,使得你能对着手机说中文,手机直接给你翻译成英文。

当飞机着陆时候,不是一个人类决定飞机该去那个登机口接驳。就好像你在网上买票时票据不是一个人类决定的。

世界最强的跳棋、象棋、拼字棋、双陆棋和黑白棋选手都是弱人工智能。

谷歌搜索是一个巨大的弱人工智能,背后是非常复杂的排序方法和内容检索。社交网络的新鲜事同样是这样。

这些还只是消费级产品的例子。军事、制造、金融(高频算法交易占到了美国股票交易的一半)等领域广泛运用各种复杂的弱人工智能。专业系统也有,比如帮助医生诊断疾病的系统,还有著名的 IBM 的华生,储存了大量事实数据,还能理解主持人的提问,在竞猜节目中能够战胜最厉害的参赛者。

你和电脑打了个平手。接着我们把图中的黑色部分去除:

你和电脑打了个平手。接着我们把图中的黑色部分去除: 你可以轻易的描述图形中透明或不透明的圆柱和 3D 图形,但是电脑就看不出来了。电脑会描述出 2D 的阴影细节,但是人脑却能够把这些阴影所展现的深度、阴影混合、房屋灯光解读出来。再看下面这张图,电脑看到的是黑白灰,我们看到的却是一块全黑的石头:

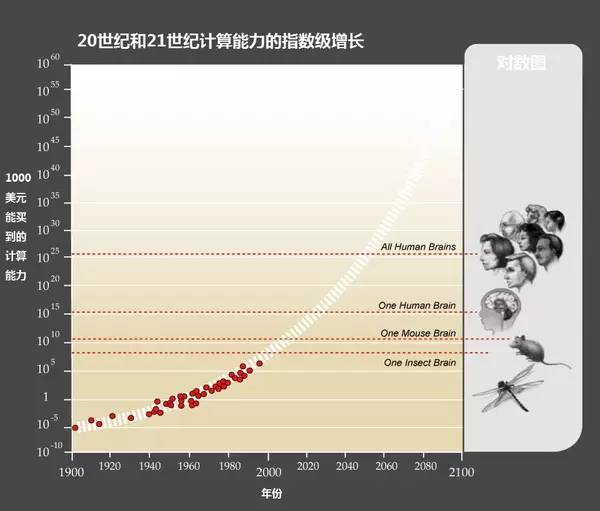

你可以轻易的描述图形中透明或不透明的圆柱和 3D 图形,但是电脑就看不出来了。电脑会描述出 2D 的阴影细节,但是人脑却能够把这些阴影所展现的深度、阴影混合、房屋灯光解读出来。再看下面这张图,电脑看到的是黑白灰,我们看到的却是一块全黑的石头: 而且,我们到现在谈的还是静态不变的信息。要想达到人类级别的智能,电脑必须要理解更高深的东西,比如微小的脸部表情变化,开心、放松、满足、满意、高兴这些类似情绪间的区别,以及为什么《布达佩斯大饭店》是好电影,而《富春山居图》是烂电影。想想就很难吧?我们要怎样才能达到这样的水平呢?通往强人工智能的第一步:增加电脑处理速度要达到强人工智能,肯定要满足的就是电脑硬件的运算能力。如果一个人工智能要像人脑一般聪明,它至少要能达到人脑的运算能力。用来描述运算能力的单位叫作 cps(calculations per second,每秒计算次数),要计算人脑的 cps 只要了解人脑中所有结构的最高 cps,然后加起来就行了。Kurzweil 把对于一个结构的最大 cps 的专业估算,然后考虑这个结构占整个大脑的重量,做乘法,来得出人脑的 cps。听起来不太靠谱,但是 Kurzweil 用了对于不同大脑区域的专业估算值,得出的最终结果都非常类似,是 10^16 cps,也就是 1 亿亿次计算每秒。现在最快的超级计算机,中国的天河二号,其实已经超过这个运算力了,天河每秒能进行 3.4 亿亿次计算。当然,天河二号占地 720 平方米,耗电 2400 万瓦,耗费了 3.9 亿美元建造。广泛应用就不提了,即使是大部分商业或者工业运用也是很贵的。Kurzweil 认为考虑电脑的发展程度的标杆是看 1000 美元能买到多少 cps,当 1000 美元能买到人脑级别的 1 亿亿运算能力的时候,强人工智能可能就是生活的一部分了。摩尔定律认为全世界的电脑运算能力每两年就翻一倍,这一定律有历史数据所支持,这同样表明电脑硬件的发展和人类发展一样是指数级别的。我们用这个定律来衡量 1000 美元什么时候能买到 1 亿亿 cps。现在 1000 美元能买到 10 万亿 cps,和摩尔定律的历史预测相符合。

而且,我们到现在谈的还是静态不变的信息。要想达到人类级别的智能,电脑必须要理解更高深的东西,比如微小的脸部表情变化,开心、放松、满足、满意、高兴这些类似情绪间的区别,以及为什么《布达佩斯大饭店》是好电影,而《富春山居图》是烂电影。想想就很难吧?我们要怎样才能达到这样的水平呢?通往强人工智能的第一步:增加电脑处理速度要达到强人工智能,肯定要满足的就是电脑硬件的运算能力。如果一个人工智能要像人脑一般聪明,它至少要能达到人脑的运算能力。用来描述运算能力的单位叫作 cps(calculations per second,每秒计算次数),要计算人脑的 cps 只要了解人脑中所有结构的最高 cps,然后加起来就行了。Kurzweil 把对于一个结构的最大 cps 的专业估算,然后考虑这个结构占整个大脑的重量,做乘法,来得出人脑的 cps。听起来不太靠谱,但是 Kurzweil 用了对于不同大脑区域的专业估算值,得出的最终结果都非常类似,是 10^16 cps,也就是 1 亿亿次计算每秒。现在最快的超级计算机,中国的天河二号,其实已经超过这个运算力了,天河每秒能进行 3.4 亿亿次计算。当然,天河二号占地 720 平方米,耗电 2400 万瓦,耗费了 3.9 亿美元建造。广泛应用就不提了,即使是大部分商业或者工业运用也是很贵的。Kurzweil 认为考虑电脑的发展程度的标杆是看 1000 美元能买到多少 cps,当 1000 美元能买到人脑级别的 1 亿亿运算能力的时候,强人工智能可能就是生活的一部分了。摩尔定律认为全世界的电脑运算能力每两年就翻一倍,这一定律有历史数据所支持,这同样表明电脑硬件的发展和人类发展一样是指数级别的。我们用这个定律来衡量 1000 美元什么时候能买到 1 亿亿 cps。现在 1000 美元能买到 10 万亿 cps,和摩尔定律的历史预测相符合。 也就是说现在 1000 美元能买到的电脑已经强过了老鼠,并且达到了人脑千分之一的水平。听起来还是弱爆了,但是,让我们考虑一下,1985 年的时候,同样的钱只能买到人脑万亿分之一的 cps,1995 年变成了十亿分之一,2005 年是百万分之一,而 2015 年已经是千分之一了。按照这个速度,我们到 **2025 年就能花 1000 美元买到可以和人脑运算速度抗衡的电脑了。**至少在硬件上,我们已经实现强人工智能了(中国的天河二号),而且十年以内,我们就能以低廉的价格买到能够支持强人工智能的电脑硬件。但是运算能力并不能让电脑变得智能,下一个问题是,我们怎样利用这份运算能力来达成人类水平的智能。通往强人工智能的第二步:让电脑变得智能这一步比较难搞。事实上,没人知道该怎么搞我们还停留在争论怎么让电脑分辨《富春山居图》是部烂片的阶段。但是,现在有一些策略,有可能会有效。下面是最常见的三种策略:1. **抄袭人脑**就好像你班上有一个学霸。你不知道为什么学霸那么聪明,为什么考试每次都满分。虽然你也很努力的学习,但是你就是考的没有学霸好。最后你决定“老子不干了,我直接抄他的考试答案好了。”这种“抄袭”是有道理的,我们想要建造一个超级复杂的电脑,但是我们有人脑这个范本可以参考呀。科学界正在努力逆向工程人脑,来理解生物进化是怎么造出这么个神奇的东西的,乐观的估计是我们在 2030 年之前能够完成这个任务。一旦这个成就达成,我们就能知道为什么人脑能够如此高效、快速的运行,并且能从中获得灵感来进行创新。一个电脑架构模拟人脑的例子就是人工神经网络。它是一个由晶体管作为“神经”组成的网络,晶体管和其它晶体管互相连接,有自己的输入、输出系统,而且什么都不知道就像一个婴儿的大脑。接着它会通过做任务来自我学习,比如识别笔迹。最开始它的神经处理和猜测会是随机的,但是当它得到正确的回馈后,相关晶体管之间的连接就会被加强;如果它得到错误的回馈,连接就会变弱。经过一段时间的测试和回馈后,这个网络自身就会组成一个智能的神经路径,而处理这项任务的能力也得到了优化。人脑的学习是类似的过程,不过比这复杂一点,随着我们对大脑研究的深入,我们将会发现更好的组建神经连接的方法。更加极端的“抄袭”方式是“整脑模拟”。具体来说就是把人脑切成很薄的片,用软件来准确的组建一个3D模型,然后把这个模型装在强力的电脑上。如果能做成,这台电脑就能做所有人脑能做的事情只要让它学习和吸收信息就好了。如果做这事情的工程师够厉害的话,他们模拟出来的人脑甚至会有原本人脑的人格和记忆,电脑模拟出的人脑就会像原本的人脑一样这就是非常符合人类标准的强人工智能,然后我们就能把它改造成一个更加厉害的超人工智能了。我们离整脑模拟还有多远呢?至今为止,我们刚刚能够模拟 1 毫米长的扁虫的大脑,这个大脑含有 302 个神经元。人类的大脑有 1000 亿个神经元,听起来还差很远。但是要记住指数增长的威力我们已经能模拟小虫子的大脑了,蚂蚁的大脑也不远了,接着就是老鼠的大脑,到那时模拟人类大脑就不是那么不现实的事情了。2. **模仿生物演化**抄学霸的答案当然是一种方法,但是如果学霸的答案太难抄了呢?那我们能不能学一下学霸备考的方法?首先我们很确定的知道,建造一个和人脑一样强大的电脑是可能的我们的大脑就是证据。如果大脑太难完全模拟,那么我们可以模拟演化出大脑的过程。事实上,就算我们真的能完全模拟大脑,结果也就好像照抄鸟类翅膀的拍动来造飞机一样很多时候最好的设计机器的方式并不是照抄生物设计。所以我们可不可以用模拟演化的方式来造强人工智能呢?这种方法叫作“基因算法”,它大概是这样的:建立一个反复运作的表现/评价过程,就好像生物通过生存这种方式来表现,并且以能否生养后代为评价一样。一组电脑将执行各种任务,最成功的将会“繁殖”,把各自的程序融合,产生新的电脑,而不成功的将会被剔除。经过多次的反复后。这个自然选择的过程将产生越来越强大的电脑。而这个方法的难点是建立一个自动化的评价和繁殖过程,使得整个流程能够自己运行。这个方法的缺点也是很明显的,演化需要经过几十亿年的时间,而我们却只想花几十年时间。但是比起自然演化来说,我们有很多优势。首先,自然演化是没有预知能力的,它是随机的它产生的没用的变异比有用的变异多很多,但是人工模拟的演化可以控制过程,使其着重于有益的变化。其次,自然演化是没有目标的,自然演化出的智能也不是它目标,特定环境甚至对于更高的智能是不利的(因为高等智能消耗很多能源)。但是我们可以指挥演化的过程超更高智能的方向发展。再次,要产生智能,自然演化要先产生其它的附件,比如改良细胞产生能量的方法,但是我们完全可以用电力来代替这额外的负担。所以,人类主导的演化会比自然快很多很多,但是我们依然不清楚这些优势是否能使模拟演化成为可行的策略。3. 让电脑来解决这些问题如果抄学霸的答案和模拟学霸备考的方法都走不通,那就干脆让考题自己解答自己吧。这种想法很无厘头,确实最有希望的一种。总的思路是我们建造一个能进行两项任务的电脑研究人工智能和修改自己的代码。这样它就不只能改进自己的架构了,我们直接把电脑变成了电脑科学家,提高电脑的智能就变成了电脑自己的任务。以上这些都会很快发生。硬件的快速发展和软件的创新是同时发生的,强人工智能可能比我们预期的更早降临,因为:

也就是说现在 1000 美元能买到的电脑已经强过了老鼠,并且达到了人脑千分之一的水平。听起来还是弱爆了,但是,让我们考虑一下,1985 年的时候,同样的钱只能买到人脑万亿分之一的 cps,1995 年变成了十亿分之一,2005 年是百万分之一,而 2015 年已经是千分之一了。按照这个速度,我们到 **2025 年就能花 1000 美元买到可以和人脑运算速度抗衡的电脑了。**至少在硬件上,我们已经实现强人工智能了(中国的天河二号),而且十年以内,我们就能以低廉的价格买到能够支持强人工智能的电脑硬件。但是运算能力并不能让电脑变得智能,下一个问题是,我们怎样利用这份运算能力来达成人类水平的智能。通往强人工智能的第二步:让电脑变得智能这一步比较难搞。事实上,没人知道该怎么搞我们还停留在争论怎么让电脑分辨《富春山居图》是部烂片的阶段。但是,现在有一些策略,有可能会有效。下面是最常见的三种策略:1. **抄袭人脑**就好像你班上有一个学霸。你不知道为什么学霸那么聪明,为什么考试每次都满分。虽然你也很努力的学习,但是你就是考的没有学霸好。最后你决定“老子不干了,我直接抄他的考试答案好了。”这种“抄袭”是有道理的,我们想要建造一个超级复杂的电脑,但是我们有人脑这个范本可以参考呀。科学界正在努力逆向工程人脑,来理解生物进化是怎么造出这么个神奇的东西的,乐观的估计是我们在 2030 年之前能够完成这个任务。一旦这个成就达成,我们就能知道为什么人脑能够如此高效、快速的运行,并且能从中获得灵感来进行创新。一个电脑架构模拟人脑的例子就是人工神经网络。它是一个由晶体管作为“神经”组成的网络,晶体管和其它晶体管互相连接,有自己的输入、输出系统,而且什么都不知道就像一个婴儿的大脑。接着它会通过做任务来自我学习,比如识别笔迹。最开始它的神经处理和猜测会是随机的,但是当它得到正确的回馈后,相关晶体管之间的连接就会被加强;如果它得到错误的回馈,连接就会变弱。经过一段时间的测试和回馈后,这个网络自身就会组成一个智能的神经路径,而处理这项任务的能力也得到了优化。人脑的学习是类似的过程,不过比这复杂一点,随着我们对大脑研究的深入,我们将会发现更好的组建神经连接的方法。更加极端的“抄袭”方式是“整脑模拟”。具体来说就是把人脑切成很薄的片,用软件来准确的组建一个3D模型,然后把这个模型装在强力的电脑上。如果能做成,这台电脑就能做所有人脑能做的事情只要让它学习和吸收信息就好了。如果做这事情的工程师够厉害的话,他们模拟出来的人脑甚至会有原本人脑的人格和记忆,电脑模拟出的人脑就会像原本的人脑一样这就是非常符合人类标准的强人工智能,然后我们就能把它改造成一个更加厉害的超人工智能了。我们离整脑模拟还有多远呢?至今为止,我们刚刚能够模拟 1 毫米长的扁虫的大脑,这个大脑含有 302 个神经元。人类的大脑有 1000 亿个神经元,听起来还差很远。但是要记住指数增长的威力我们已经能模拟小虫子的大脑了,蚂蚁的大脑也不远了,接着就是老鼠的大脑,到那时模拟人类大脑就不是那么不现实的事情了。2. **模仿生物演化**抄学霸的答案当然是一种方法,但是如果学霸的答案太难抄了呢?那我们能不能学一下学霸备考的方法?首先我们很确定的知道,建造一个和人脑一样强大的电脑是可能的我们的大脑就是证据。如果大脑太难完全模拟,那么我们可以模拟演化出大脑的过程。事实上,就算我们真的能完全模拟大脑,结果也就好像照抄鸟类翅膀的拍动来造飞机一样很多时候最好的设计机器的方式并不是照抄生物设计。所以我们可不可以用模拟演化的方式来造强人工智能呢?这种方法叫作“基因算法”,它大概是这样的:建立一个反复运作的表现/评价过程,就好像生物通过生存这种方式来表现,并且以能否生养后代为评价一样。一组电脑将执行各种任务,最成功的将会“繁殖”,把各自的程序融合,产生新的电脑,而不成功的将会被剔除。经过多次的反复后。这个自然选择的过程将产生越来越强大的电脑。而这个方法的难点是建立一个自动化的评价和繁殖过程,使得整个流程能够自己运行。这个方法的缺点也是很明显的,演化需要经过几十亿年的时间,而我们却只想花几十年时间。但是比起自然演化来说,我们有很多优势。首先,自然演化是没有预知能力的,它是随机的它产生的没用的变异比有用的变异多很多,但是人工模拟的演化可以控制过程,使其着重于有益的变化。其次,自然演化是没有目标的,自然演化出的智能也不是它目标,特定环境甚至对于更高的智能是不利的(因为高等智能消耗很多能源)。但是我们可以指挥演化的过程超更高智能的方向发展。再次,要产生智能,自然演化要先产生其它的附件,比如改良细胞产生能量的方法,但是我们完全可以用电力来代替这额外的负担。所以,人类主导的演化会比自然快很多很多,但是我们依然不清楚这些优势是否能使模拟演化成为可行的策略。3. 让电脑来解决这些问题如果抄学霸的答案和模拟学霸备考的方法都走不通,那就干脆让考题自己解答自己吧。这种想法很无厘头,确实最有希望的一种。总的思路是我们建造一个能进行两项任务的电脑研究人工智能和修改自己的代码。这样它就不只能改进自己的架构了,我们直接把电脑变成了电脑科学家,提高电脑的智能就变成了电脑自己的任务。以上这些都会很快发生。硬件的快速发展和软件的创新是同时发生的,强人工智能可能比我们预期的更早降临,因为:指数级增长的开端可能像蜗牛漫步,但是后期会跑的非常快

软件的发展可能看起来很缓慢,但是一次顿悟,就能永远改变进步的速度。就好像在人类还信奉地心说的时候,科学家们没法计算宇宙的运作方式,但是日心说的发现让一切变得容易很多。创造一个能自我改进的电脑来说,对我们来说还很远,但是可能一个无意的变动,就能让现在的系统变得强大千倍,从而开启朝人类级别智能的冲刺。

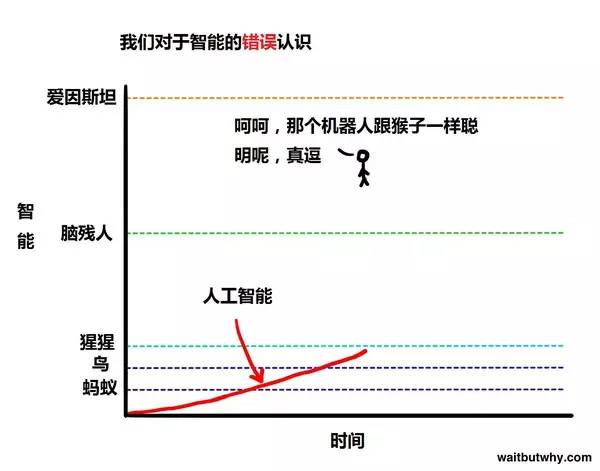

所以,当人工智能开始朝人类级别智能靠近时,我们看到的是它逐渐变得更加智能,就好像一个动物一般。然后,它突然达到了最愚笨的人类的程度,我们到时也许会感慨:“看这个人工智能就跟个脑残人类一样聪明,真可爱。”但问题是,从智能的大局来看,人和人的智能的差别,比如从最愚笨的人类到爱因斯坦的差距,其实是不大的。所以当人工智能达到了脑残级别的智能后,它会很快变得比爱因斯坦更加聪明:

所以,当人工智能开始朝人类级别智能靠近时,我们看到的是它逐渐变得更加智能,就好像一个动物一般。然后,它突然达到了最愚笨的人类的程度,我们到时也许会感慨:“看这个人工智能就跟个脑残人类一样聪明,真可爱。”但问题是,从智能的大局来看,人和人的智能的差别,比如从最愚笨的人类到爱因斯坦的差距,其实是不大的。所以当人工智能达到了脑残级别的智能后,它会很快变得比爱因斯坦更加聪明: 之后呢?智能爆炸从这边开始,这个话题要变得有点吓人了。我在这里要提醒大家,以下所说的都是大实话是一大群受人尊敬的思想家和科学家关于未来的诚实的预测。你在下面读到什么离谱的东西的时候,要记得这些东西是比你我都聪明很多的人想出来的。像上面所说的,我们当下用来达成强人工智能的模型大多数都依靠人工智能的自我改进。但是一旦它达到了强人工智能,即使算上那一小部分不是通过自我改进来达成强人工智能的系统,也会聪明到能够开始自我改进。这里我们要引出一个沉重的概念递归的自我改进。这个概念是这样的:一个运行在特定智能水平的人工智能,比如说脑残人类水平,有自我改进的机制。当它完成一次自我改进后,它比原来更加聪明了,我们假设它到了爱因斯坦水平。而这个时候它继续进行自我改进,然而现在它有了爱因斯坦水平的智能,所以这次改进会比上面一次更加容易,效果也更好。第二次的改进使得他比爱因斯坦还要聪明很多,让它接下来的改进进步更加明显。如此反复,这个强人工智能的智能水平越长越快,直到它达到了超人工智能的水平这就是智能爆炸,也是加速回报定律的终极表现。

之后呢?智能爆炸从这边开始,这个话题要变得有点吓人了。我在这里要提醒大家,以下所说的都是大实话是一大群受人尊敬的思想家和科学家关于未来的诚实的预测。你在下面读到什么离谱的东西的时候,要记得这些东西是比你我都聪明很多的人想出来的。像上面所说的,我们当下用来达成强人工智能的模型大多数都依靠人工智能的自我改进。但是一旦它达到了强人工智能,即使算上那一小部分不是通过自我改进来达成强人工智能的系统,也会聪明到能够开始自我改进。这里我们要引出一个沉重的概念递归的自我改进。这个概念是这样的:一个运行在特定智能水平的人工智能,比如说脑残人类水平,有自我改进的机制。当它完成一次自我改进后,它比原来更加聪明了,我们假设它到了爱因斯坦水平。而这个时候它继续进行自我改进,然而现在它有了爱因斯坦水平的智能,所以这次改进会比上面一次更加容易,效果也更好。第二次的改进使得他比爱因斯坦还要聪明很多,让它接下来的改进进步更加明显。如此反复,这个强人工智能的智能水平越长越快,直到它达到了超人工智能的水平这就是智能爆炸,也是加速回报定律的终极表现。 现在关于人工智能什么时候能达到人类普遍智能水平还有争议。对于数百位科学家的问卷调查显示他们认为强人工智能出现的中位年份是 2040 年距今只有 25 年。这听起来可能没什么,但是要记住,很多这个领域的思想家认为从强人工智能到超人工智能的转化会快得多。以下的情景很可能会发生:一个人工智能系统花了几十年时间到达了人类脑残智能的水平,而当这个节点发生的时候,电脑对于世界的感知大概和一个四岁小孩一般;而在这节点后一个小时,电脑立马推导出了统一广义相对论和量子力学的物理学理论;而在这之后一个半小时,这个强人工智能变成了超人工智能,智能达到了普通人类的 **17 万倍。**这个级别的超级智能不是我们能够理解的,就好像蜜蜂不会理解凯恩斯经济学一样。在我们的语言中,我们把 **130 的智商叫作聪明,把 85 的智商叫作笨,但是我们不知道怎么形容 12952 **的智商,人类语言中根本没这个概念。但是我们知道的是,人类对于地球的统治教给我们一个道理智能就是力量。也就是说,一个超人工智能,一旦被创造出来,将是地球有史以来最强大的东西,而所有生物,包括人类,都只能屈居其下而这一切,有可能在未来几十年就发生。想一下,如果我们的大脑能够发明 Wi-Fi,那么一个比我们聪明 100 倍、1000 倍、甚至 10 亿倍的大脑说不定能够随时随地操纵这个世界所有原子的位置。那些在我们看来超自然的,只属于全能的上帝的能力,对于一个超人工智能来说可能就像按一下电灯开关那么简单。防止人类衰老,治疗各种不治之症,解决世界饥荒,甚至让人类永生,或者操纵气候来保护地球未来的什么,这一切都将变得可能。同样可能的是地球上所有生命的终结。当一个超人工智能出生的时候,对我们来说就像一个全能的上帝降临地球一般。这时候我们所关心的就是

现在关于人工智能什么时候能达到人类普遍智能水平还有争议。对于数百位科学家的问卷调查显示他们认为强人工智能出现的中位年份是 2040 年距今只有 25 年。这听起来可能没什么,但是要记住,很多这个领域的思想家认为从强人工智能到超人工智能的转化会快得多。以下的情景很可能会发生:一个人工智能系统花了几十年时间到达了人类脑残智能的水平,而当这个节点发生的时候,电脑对于世界的感知大概和一个四岁小孩一般;而在这节点后一个小时,电脑立马推导出了统一广义相对论和量子力学的物理学理论;而在这之后一个半小时,这个强人工智能变成了超人工智能,智能达到了普通人类的 **17 万倍。**这个级别的超级智能不是我们能够理解的,就好像蜜蜂不会理解凯恩斯经济学一样。在我们的语言中,我们把 **130 的智商叫作聪明,把 85 的智商叫作笨,但是我们不知道怎么形容 12952 **的智商,人类语言中根本没这个概念。但是我们知道的是,人类对于地球的统治教给我们一个道理智能就是力量。也就是说,一个超人工智能,一旦被创造出来,将是地球有史以来最强大的东西,而所有生物,包括人类,都只能屈居其下而这一切,有可能在未来几十年就发生。想一下,如果我们的大脑能够发明 Wi-Fi,那么一个比我们聪明 100 倍、1000 倍、甚至 10 亿倍的大脑说不定能够随时随地操纵这个世界所有原子的位置。那些在我们看来超自然的,只属于全能的上帝的能力,对于一个超人工智能来说可能就像按一下电灯开关那么简单。防止人类衰老,治疗各种不治之症,解决世界饥荒,甚至让人类永生,或者操纵气候来保护地球未来的什么,这一切都将变得可能。同样可能的是地球上所有生命的终结。当一个超人工智能出生的时候,对我们来说就像一个全能的上帝降临地球一般。这时候我们所关心的就是

这篇文章的第一部分完了,我建议你休息一下,喝点水,下面我们要开始第二部分。

因微信限制,单条图文消息不能超过 2 万字,而本文章篇幅过长,微信不能完整呈现,阅读完整文章请点击本页面最下方“阅读原文”跳转到作者的知乎专栏。

查看评论 回复