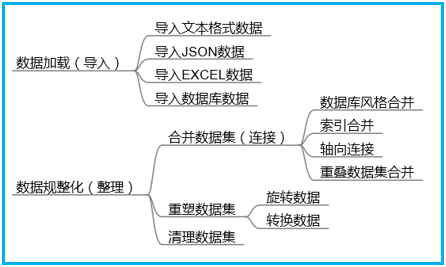

python数据分析笔记数据加载与整理

戳蓝字关注我们!

戳蓝字关注我们!

作者 张俊红

本文为 CDA 志愿者张俊红原创作品,转载需授权

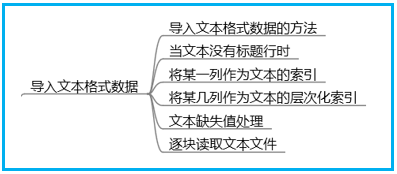

导入文本数据

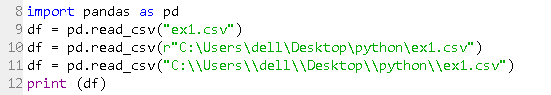

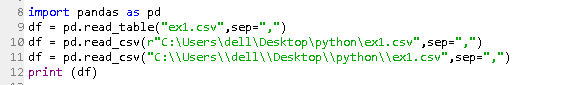

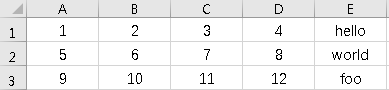

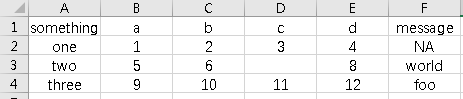

1、导入文本格式数据(CSV)的方法:

方法一:使用 pd.read_csv(),默认打开 csv 文件。

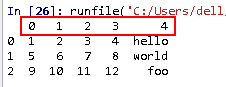

9、10、11 行三种方式均可以导入文本格式的数据。

特殊说明:第 9 行使用的条件是运行文件.py 需要与目标文件 CSV 在一个文件夹中的时候可以只写文件名。第 10 和 11 行中文件名 ex1.CSV 前面的部分均为文件的路径。

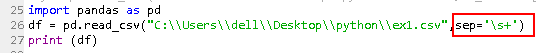

方法二:使用 pd.read.table(),需要指定是什么样分隔符的文本文件。用 sep=””来指定。

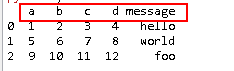

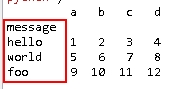

2、当文件没有标题行时

可以让 pandas 为其自动分配默认的列名。

也可以自己定义列名。

3、将某一列作为索引,比如使用 message 列做索引。通过 index_col 参数指定’message’。

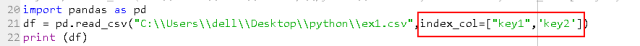

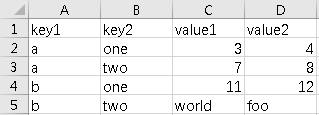

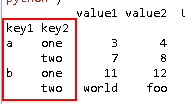

4、要将多个列做成一个层次化索引,只需传入由列编号或列名组成的列表即可。

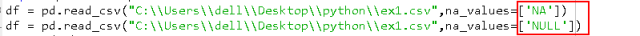

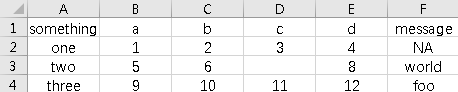

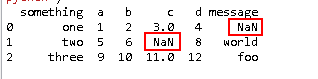

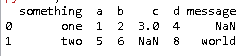

5、文本中缺失值处理,缺失数据要么是没有(空字符串),要么是用某个标记值表示的,默认情况下,pandas 会用一组经常出现的标记值进行识别,如 NA 、NULL 等。查找出结果以 NAN 显示。

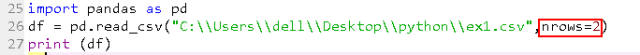

6、逐块读取文本文件

如果只想读取几行(避免读取整个文件),通过 nrows 进行制定即可。

7、对于不是使用固定分隔符分割的表格,可以使用正则表达式来作为 read_table 的分隔符。

(’s+’是正则表达式中的字符)。

导入 JSON 数据

JSON 数据是通过 HTTP 请求在 Web 浏览器和其他应用程序之间发送数据的标注形式之一。通过 json.loads 即可将 JSON 对象转换成 Python 对象。(import json)

对应的json.dumps则将Python对象转换成JSON格式。

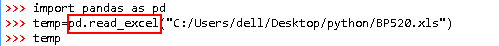

导入 EXCEL 数据

直接使用 read_excel(文件名路径)进行获取,与读取 CSV 格式的文件类似。

导入数据库数据

主要包含两种数据库文件,一种是 SQL 关系型数据库数据,另一种是非 SQL 型数据库数据即 MongoDB 数据库文件。

数据库文件是这几种里面比较难的,本人没有接触数据库文件,没有亲测,所以就不贴截图了。

数据整理合并数据集

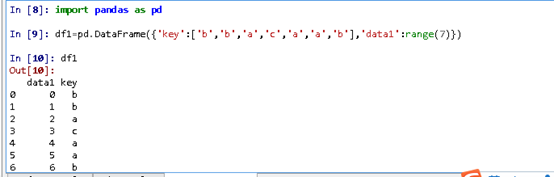

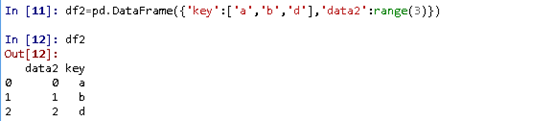

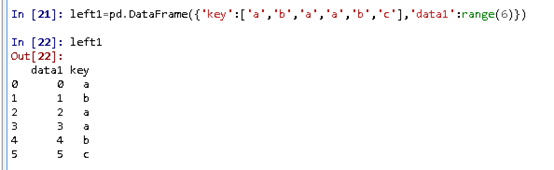

1、数据库风格的合并

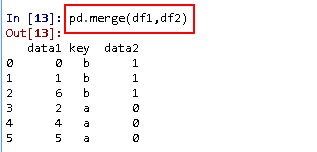

数据库风格的合并与 SQL 数据库中的连接( join )原理一样。通过调用 merge 函数即可进行合并。

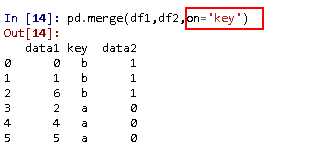

当没有指明用哪一列进行连接时,程序将自动按重叠列的列名进行连接,上述语句就是按重叠列“key”列进行连接。也可以通过 on 来指定连接列进行连接。

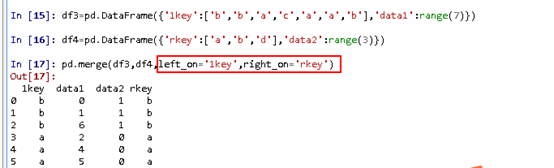

当两个对象的列名不同时,即两个对象没有共同列时,也可以分别进行指定。

Left_on 是指左侧 DataFrame 中用作连接的列。

right_on 是指右侧 DataFrame 中用作连接的列。

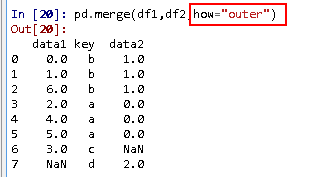

通过上面的语句得到的结果里面只有 a 和 b 对应的数据,c 和 d 以及与之相关的数据被消去,这是因为默认情况下,merge 做的是‘inner’连接,即 sql 中的内连接,取得两个对象的交集。也有其他方式连接:left、right、outer。用“how”来指明。

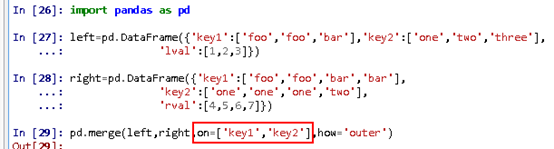

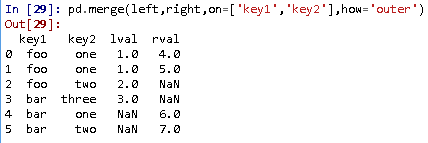

也可以根据多个键(列)进行合并,用 on 传入一个由列名组成的列表即可。

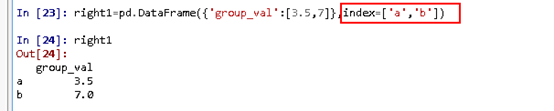

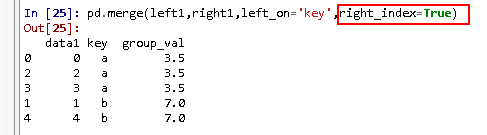

2、索引上的合并

(1)普通索引的合并

Left_index 表示将左侧的行索引引用做其连接键

right_index 表示将右侧的行索引引用做其连接键

上面两个用于 DataFrame 中的连接键位于其索引中,可以使用 Left_index=True 或 right_index=True 或两个同时使用来进行键的连接。

(2)层次化索引

与数据库中用 on 来根据多个键合并一样。

3、轴向连接(合并)

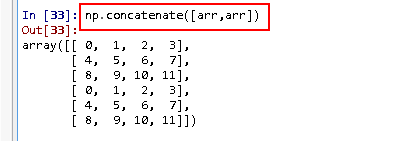

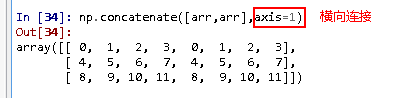

轴向连接,默认是在轴方向进行连接,也可以通过 axis=1 使其进行横向连接。

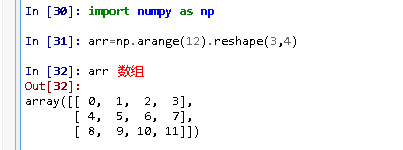

(1)对于 numpy 对象(数组)可以用 numpy 中的 concatenation 函数进行合并。

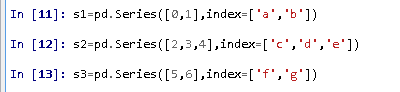

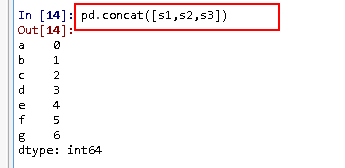

(2)对于 pandas 对象(如 Series 和 DataFrame),可以 pandas 中的 concat 函数进行合并。

4、合并重叠数据

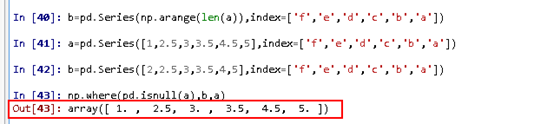

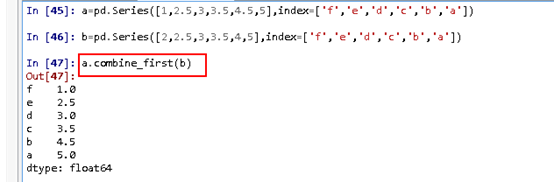

对于索引全部或部分重叠的两个数据集,我们可以使用 numpy 的 where 函数来进行合并,where 函数相当于 ifelse 函数。

对于重复的数据显示出相同的数据,而对于不同的数据显示 a 列表的数据。同时也可以使用 combine_first 的方法进行合并。合并原则与 where 函数一致,遇到相同的数据显示相同数据,遇到不同的显示a列表数据。

重塑数据集

1、旋转数据

(1)重塑索引、分为 stack (将数据的列旋转为行)和 unstack (将数据的行旋转为列)。

(2)将‘长格式’旋转为‘宽格式’

2、转换数据

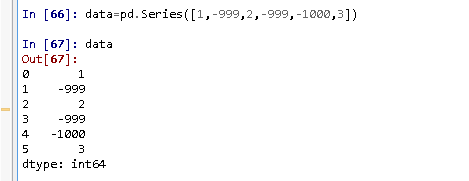

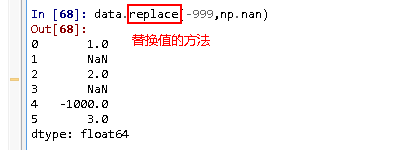

(1)数据替换,将某一值或多个值用新的值进行代替。(比较常用的是缺失值或异常值处理,缺失值一般都用 NULL 、NAN 标记,可以用新的值代替缺失标记值)。方法是 replace。

一对一替换:用 np.nan 替换 -999

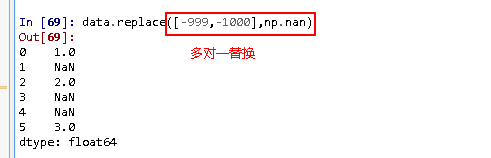

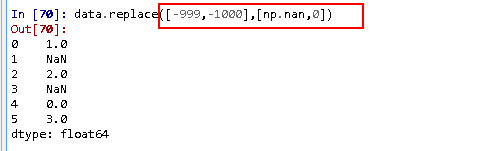

多对一替换:用 np.nan 替换 -999 和 -1000.

多对多替换:用 np.nan 代替 -999,0 代替 -1000.

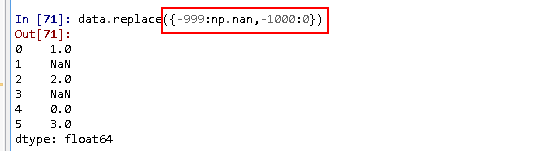

也可以使用字典的形式来进行替换。

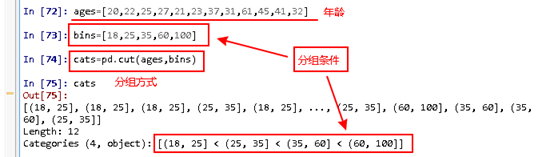

(2)离散化或面元划分,即根据某一条件将数据进行分组。

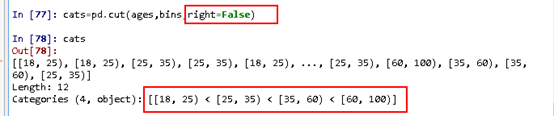

利用 pd.cut()方式对一组年龄进行分组。

默认情况下,cut 对分组条件的左边是开着的状态,右边是闭合状态。可以用 left(right)=False 来设置哪边是闭合的。

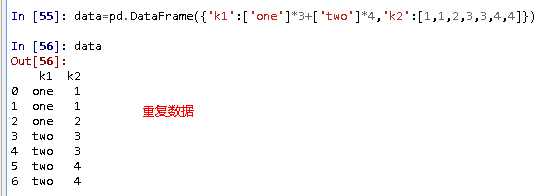

清理数据集

主要是指清理重复值,DataFrame 中经常会出现重复行,清理数据主要是针对这些重复行进行清理。

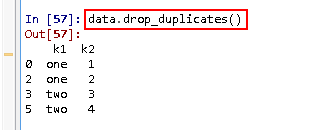

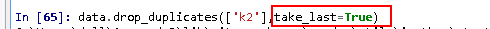

利用 drop_duplicates 方法,可以返回一个移除了重复行的 DataFrame.

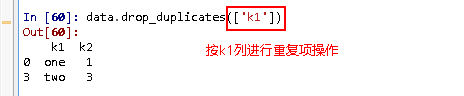

默认情况下,此方法是对所有的列进行重复项清理操作,也可以用来指定特定的一列或多列进行。

默认情况下,上述方法保留的是第一个出现的值组合,传入 take_last=true 则保留最后一个。

![]()

查看评论 回复